ETL Architecture : Découvrez les trois étapes d’un projet ETL – Extract Transform Load

23 juin 2020

23 juin 2020

L’ETL architecture dépendra de votre projet d’intégration de données. D’ailleurs, ETL et EAI (« Entreprise Application Intégration) » sont deux éléments principaux d’un projet de ce type. A quoi sert un ETL pour une DSI ? comment réaliser mon ETL architecture et quels liens y-a-il avec le bigData ? Autant de réponses que nous traiterons dans le présent article.

Si nous avons déjà identifié les différences entre ETL et EAI, il convient tout de même de rappeler ce qu’apporte un ETL dans une architecture de Système d’Information. Un ETL permet d’automatiser les traitements d’alimentation des entrepôts de données. Ses fonctions sont de collecter des données provenant de sources différentes, de les traiter et de les charger dans un entrepôt de données. On parle aussi d’ETL integration. Alors qu’un EAI permet d’automatiser les échanges de données entre applications (Data Integration).

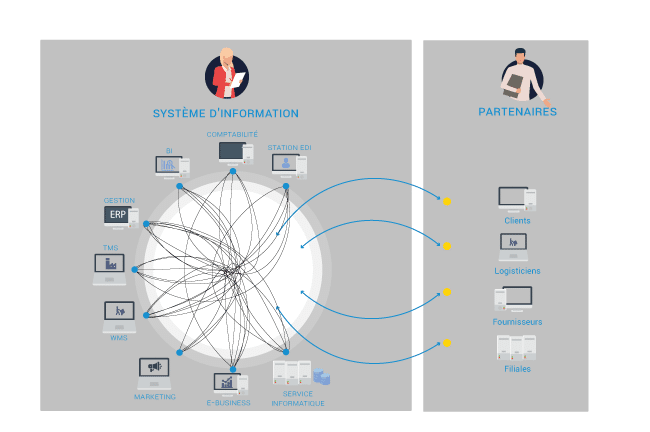

Les systèmes d’information des entreprises sont de natures hétérogènes, plusieurs sources de données, de générations différentes, ERP (Enterprise Ressource Planning), CRM (Customer Ressource Management), Gestion de production, et autres progiciels… Toutes ces bases de données sont toutes optimisées pour des transactions à des fins métiers et applicatives.

En effet vos datas sont de sources multiples et de structures de données différentes, le traitement des données n’en est que plus complexe. De même il y a de possibles redondances d’informations : cet état est un obstacle à une analyse facile et rapide des données de l’entreprise. Évitez le syndrome du plat de spaghetti !

La solution pour votre ETL architecture : collecter toutes les données pertinentes de l’entreprise dans un Data Wharehouse ou entrepôt de données. Les données seront alors organisées à des fins d’analyse dans un référentiel de données. L’outil idéal pour améliorer la qualité des données. Les travaux de Ralph Kimball et Bill Inmon décrivent largement comment construire un Data Wharehouse qui répond aux besoins Business Intelligence de l’entreprise. On y retrouve les prémisses de notions d’ETL architecture.

Un ETL doit être en mesure de collecter, en temps réel ou par batch, toutes sortes de données brutes, données structurées, données non structurées ; en provenance des différentes sources du système d’information de l’entreprise, sur site et sur le cloud.

Cette étape consiste à extraire de l’ensemble des bases de données (Oracle, SAP, MySQL, …) des applications de l’entreprise. Cette opération nécessite l’utilisation de plusieurs technologies adaptées au type de la source de données : des passerelles, des utilitaires de réplication, des extracteurs, des connecteurs, des API.

A cette étape, il est envisageable de faire à appel à des MPP (Massivelly Parallel Processing), pour se connecter simultanément à un grand nombre de base de données.

Cette étape est la plus importante, elle garantit la qualité des données que votre ETL architecture va intégrer dans l’entrepôt de données.

Pour chaque nature de données, origine de données, des règles précises sont définies pour :

L’objectif est de produire des données propres prêtes à être chargées dans le Data Warehouse et à servir de source pour les solutions d’analyse.

Après cette étape, les données stockées sont facilement accessibles et utilisables :

Pour des gains de performance ces trois étapes, extract transform load, s’effectuent souvent en parallèle.

La transformation numérique des entreprises à l’ère du Big Data multiplie les sources de données : IoT (Internet of Things), OpenData, Site e-commerce, Réseaux Sociaux, pages Web, …, et les nouveaux types de données non structurées et présentes en de très grandes quantités.

Il est donc nécessaire de soigner la scalabilité de l’architecture d’un projet ETL pour anticiper ces nouvelles données.

Comme pour la plupart des logiciels l’offre ETL architecture se décline :

Si cet article vous a plus, a lire aussi celui sur les 10 bonnes raisons de passer au MDM (Master Data Management), ou encore celui sur l’amélioration de la qualité des données.

Depuis plus de trente ans, Tenor accompagne les entreprises dans leur transformation digitale. Nos consultant vous proposent des solutions d’intégration, d’automatisation et d’intégration. Nous proposons des solutions de gestion de données comme les ETL informatique. Contactez nos équipes pour lancer votre projet.